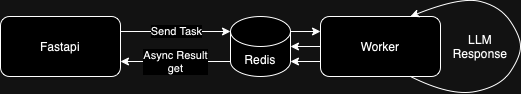

서론 로컬 LLM 모델을 이용한 챗봇 서비스를 만들고 있다. 웹서비스 개발은 처음으로 하고 있어서, copilot과 ChatGPT, 구글링 등 여러군데에서 적당한 개발 방식을 찾아서 적용해 보고있다. 여러시도 중에 백앤드로 Fastapi를 사용해서 별도의 Worker서버에 Celery를 통한 요청으로 LLM response를 받는 방식으로 서비스를 구현하려고 하고있어 그 예제를 정리하여 올린다. 구성도 백앤드에서 redis를 브로커로 이용하여 worker서버에 작업 요청과 결과를받아오는 구성이다. 필요 패키지 fastapi , uvicorn, celery, redis pip install fastapi celery redis "uvicorn[standard]" Redis 사용 Docker를 이용하여 Re..